<dfn id="2awkm"></dfn> <dfn id="2awkm"></dfn> 全球機(jī)器人領(lǐng)域最具影響力的學(xué)術(shù)會議IROS 2025于10月19日至25日在杭州國際博覽中心舉行。大會收錄的多篇論文的研究成果采用了奧比中光的3D視覺技術(shù),涵蓋自動化掃描、空間建模、人機(jī)交互等前沿方向,彰顯了奧比中光在全球機(jī)器人與AI視覺研究領(lǐng)域的底層支撐地位。

頂級學(xué)術(shù)會議見證技術(shù)實(shí)力

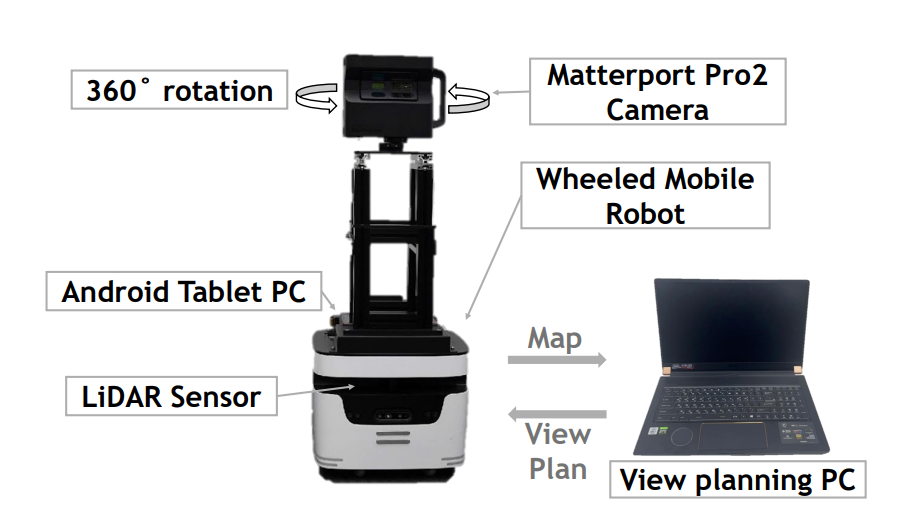

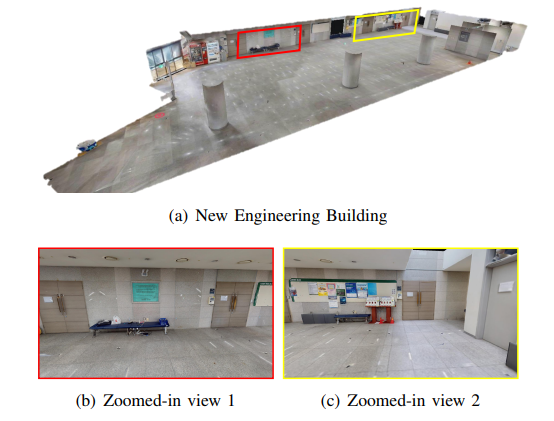

在本屆IROS收錄的論文中,韓國梨花女子大學(xué)團(tuán)隊(duì)的“Scanning Bot: Efficient Scan Planning using Panoramic Cameras”提出的“Scanning Bot”系統(tǒng)采用奧比中光Astra相機(jī)模組(集成于Matterport Pro2全景攝像系統(tǒng))進(jìn)行高精度室內(nèi)3D掃描與重建,顯著提升了掃描效率與紋理質(zhì)量[1]。

上海交通大學(xué)團(tuán)隊(duì)的論文“Zero-Shot Temporal Interaction Localization for Egocentric Videos”提出了一種可泛化的零樣本模型“EgoLoc”,通過第一視角視頻時(shí)序交互定位方法研究人機(jī)協(xié)作與模仿學(xué)習(xí),利用RGB-D視覺理解人類動作與物體交互。奧比中光的Femto Bolt相機(jī)通過采集訓(xùn)練數(shù)據(jù),為模型的三維理解能力提供關(guān)鍵支撐[2]。

圖片來源:Lee, E., Han, K. M., & Kim, Y. J. (2025). Scanning Bot: Efficient Scan Planning using Panoramic Cameras.

奧比中光相機(jī)具備開放的SDK生態(tài)、可調(diào)參的深度質(zhì)量控制、穩(wěn)定的多機(jī)位時(shí)間同步能力,以及對弱光、低紋理、反光材質(zhì)等復(fù)雜場景的魯棒性——這些特性讓科研成果具備更高的可復(fù)現(xiàn)性和落地潛力。

具身智能成為IROS 2025核心趨勢

本屆大會特別關(guān)注具身智能(Embodied AI)的發(fā)展,強(qiáng)調(diào)機(jī)器人感知、認(rèn)知與行動的深度融合。大會聚焦無人機(jī)、自動駕駛、大語言模型、靈巧手以及具身智能等關(guān)鍵領(lǐng)域,多個(gè)工作坊專注于多模態(tài)感知——包括觸覺、視覺和語言模型——在復(fù)雜環(huán)境中實(shí)現(xiàn)靈巧、適應(yīng)性的機(jī)器人行為。

在這一背景下,這兩篇用到奧比中光相機(jī)的論文正好映射出前沿路線的兩個(gè)端點(diǎn):

在交互理解方向,EgoLoc將深度與動力學(xué)先驗(yàn)(如手部三維速度、接觸/分離瞬時(shí)特征)顯式并入模型,以期在零樣本或小樣本條件下穩(wěn)定定位“什么時(shí)候交互”。

在掃描與重建方向,Scanning Bot則以 “可見性約束 → 視點(diǎn)集最小化 → 路徑可行性 → 總時(shí)長最優(yōu)” 為設(shè)計(jì)框架,追求覆蓋率>99%的高效端到端掃描流程。

從這些具體研究可以進(jìn)一步觀察到,IROS 2025凝聚出以下幾條機(jī)器人技術(shù)演進(jìn)的共識:

多機(jī)位一致性成為剛需:要維持時(shí)序理解與全景拼接性能,外參穩(wěn)定、時(shí)間戳準(zhǔn)確、低抖動觸發(fā)是基礎(chǔ)保障。

本地化開放生態(tài)優(yōu)于黑盒式集成:ROS 2、Unity/UE 支持、可插拔數(shù)據(jù)流程與深度質(zhì)量調(diào)優(yōu)能力,正在成為評判視覺設(shè)備架構(gòu)設(shè)計(jì)的關(guān)鍵要素。

場景魯棒性與一致性評測成為研究指標(biāo):弱光、低紋理、反射材質(zhì)環(huán)境下深度穩(wěn)定性不可弱化;覆蓋率、重疊度與總時(shí)長等任務(wù)級KPI被納入評測協(xié)議和方法目標(biāo)。

在這些趨勢之中,3D視覺正逐步從“感知工具”躍升為機(jī)器人系統(tǒng)中承接物理世界與 AI 決策層的關(guān)鍵橋梁。

持續(xù)賦能全球?qū)W術(shù)與產(chǎn)業(yè)創(chuàng)新

被譽(yù)為“機(jī)器人研究奧林匹克盛會”的IEEE/RSJ國際智能機(jī)器人與系統(tǒng)會議(IROS),是全球機(jī)器人領(lǐng)域最具影響力的學(xué)術(shù)會議之一,自1988年創(chuàng)辦以來一直推動著機(jī)器人技術(shù)的前沿發(fā)展。今年大會匯聚了超過7000名來自全球的專家、學(xué)者和業(yè)界專業(yè)人士,展示最前沿的學(xué)術(shù)成果和技術(shù)趨勢。

作為“機(jī)器人與AI視覺中臺”,奧比中光對結(jié)構(gòu)光、iToF、雙目、dToF、激光雷達(dá)、工業(yè)三維測量等技術(shù)路線進(jìn)行了全領(lǐng)域布局,已服務(wù)全球超過3000家客戶。公司持續(xù)支持產(chǎn)學(xué)研協(xié)作,連續(xù)多年參與中國三維視覺大會(China3DV)和CVPR等國際學(xué)術(shù)會議。奧比中光為全球科研與產(chǎn)業(yè)創(chuàng)新提供底層支撐,共同推動3D視覺技術(shù)在機(jī)器人、自動化與人機(jī)協(xié)作領(lǐng)域的融合創(chuàng)新。

[1] Lee, E., Han, K. M., & Kim, Y. J. (2025). Scanning Bot: Efficient Scan Planning using Panoramic Cameras.

[2] Ma, J., Zhang, E., Zheng, Y. D., Xie, Y., Zhou, Y., & Wang, H. (2025). Zero-Shot Temporal Interaction Localization for Egocentric Videos

分享到

<dfn id="2awkm"></dfn> <dfn id="2awkm"></dfn>